HBM 수요 60%↑ AI서버 출하량 연 120만대 38%↑

[SRT(에스알 타임스) 선호균 기자] 인공지능(AI) 서버 출하량 증가(38%)에 맞춰 고대역폭메모리(HBM) 수요가 연간 60%가 넘을 것이란 전망이 나왔다.

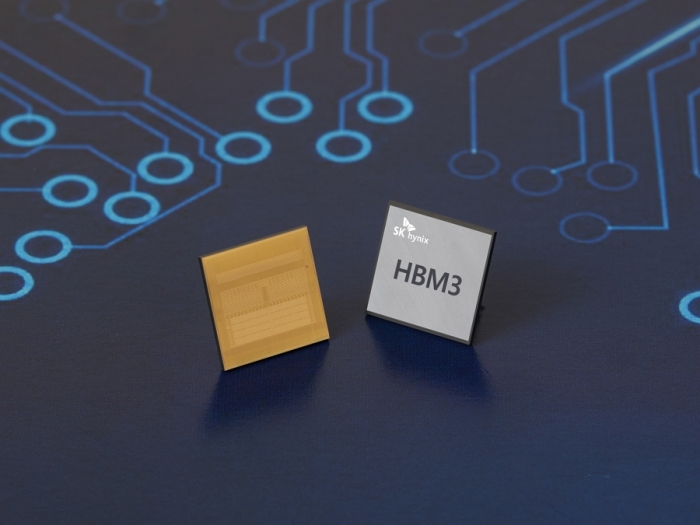

29일 대만 시장조사업체 트렌드포스에 따르면 D램(DDR SDRAM)의 대역폭 제한으로 인해 생기는 메모리 전송 속도 제한으로 HBM의 전송 효율성이 인정받고 있다. 이는 HBM이 연산작용을 담당하는 중앙처리장치(CPU)가 최대 용량으로 작동하는데 중요한 역할을 담당한다는 것을 나타낸다.

세계 시장에서 최상위 AI 서버에 들어있는 그래픽처리장치(GPU)는 HBM을 사용해 새로운 업계 표준을 설정했다. 트렌드포스는 HBM 글로벌 수요가 올해 60% 증가한 2억9,000만GB에 도달할 것으로 내다봤다. 또 내년에는 올해 대비 30% 성장할 것으로 예측했다.

2025년에는 챗GPT에 해당하는 인공지능생성콘텐츠(AIGC) 제품을 고려했을 때 전 세계적으로 필요한 최소 컴퓨팅 자원은 엔비디아 A100 GPU 기준으로 14만5,600개에서 23만3,700개가 소요될 것으로 트렌드포스는 전망했다.

슈퍼컴퓨터, 8K 비디오 스트리밍, 가상·증강현실 등 신기술들은 고속 컴퓨팅에 대한 수요 증가로 인해 클라우드 컴퓨팅 시스템의 워크로드를 동시에 증가시킬 것이란 관측이 나온다. HBM은 DDR SDRAM에 비해 더 높은 대역폭과 더 낮은 에너지 소비 덕분에 고속 컴퓨팅 플랫폼을 구축하는데 더 우수한 솔루션으로 평가받고 있다. 더 높은 전송 성능을 추구하면 필연적으로 전력 소비가 증가하는데 이는 잠재적으로 시스템 성능에 부정적인 영향을 미칠 수밖에 없다는 것이다.

트렌드포스 관계자는 “현재 HBM 수요 증가의 주 원인은 엔비디아 A100과 H100, AMD MI300이 탑재된 AI서버와 자체 주문형반도체(ASIC)를 개발 중인 구글, 아마존웹서비스 등 대형 클라우드 서비스 제공업체”라며 “GPU, FPGA, ASIC을 탑재한 서버를 포함한 AI서버 출하량은 올해 120만대에 달해 연간 38%의 성장률을 기록할 것으로 추정한다”고 말했다.

그러면서 “AI반도체 출하량도 동시에 급증해 잠재 성장률이 50%를 넘을 것으로 기대한다”고 덧붙였다.

- SK하이닉스, 10나노급 5세대 DDR5 '호환성 검증' 돌입

- SK하이닉스, 올 1분기 영업손실 3조4,023억원…'사상 최대 적자'

- [SR재계] 이재용 회장, 천안·온양 캠퍼스 방문…인재 양성·미래 기술 투자 강조

- [SR전자IT] SK하이닉스, 지난해 4분기 메모리 반도체 부진에 1조7,000억원 영업손실

- KT-KT클라우드-삼성전자, 차세대 메모리 협력 MOU…AI 풀스택

- 삼성전자, 반도체부문 부사장급 인사 단행

- SK스퀘어·하이닉스, TGC 스퀘어 법인 설립…신한금융·LIG넥스원 공동 출자

- [SR창간기획] 삼성전자·SK하이닉스, 각기 다른 '반도체' 전략

- SK하이닉스, 세계 최고층 321단 낸드 샘플 공개

- SK하이닉스, 최고사양 HBM3E 개발…샘플공급·성능검증